TensorFlowハンズオン @Google

なんとなくTwitter見ていたら、六本木のGoogleでやるディープ・ラーニング(TensorFlow)のハンズオン会を見つけて応募したところ、とんでもない倍率になってしまい、もちろん落選、補欠待ちになった。

まぁ補欠繰り上がりも無理なので、Youtube配信で受講することに。。。

アジェンダ

- 最近のデープ・ラーニング話題?(聴講できなかった、、、) 【サトウさん】

- ニューラルネットワークとディープ・ラーニングの話 【丸山不二夫さん(MaruLabo)】

- ハンズオンの環境整備 【シモダさん】

- TensorFlowでMNISTを動かしてみるハンズオン 【フルカワさん】

最近のデープ・ラーニング話題?(聴講できなかった、、、) 【サトウさん】

連絡が来たYoutubeのURLが間違ってて、上手く聞けなかったー。資料ほしー。

ニューラルネットワークとディープ・ラーニングの話 【丸山不二夫さん(MaruLabo)】

後から考えると、この話がメインだった気がする。資料が280ページ超えですごい。

ニューラルネットワークの基礎から、詳細計算の勘所までを分かりやすく解説してくださった。

DNNとCNNの違いとか、ニューロン、活性化関数、softmax、Backpropagation、クロスエントロピーの話、、、復讐すべきことがたーくさん!

ハンズオンの環境整備【シモダさん】

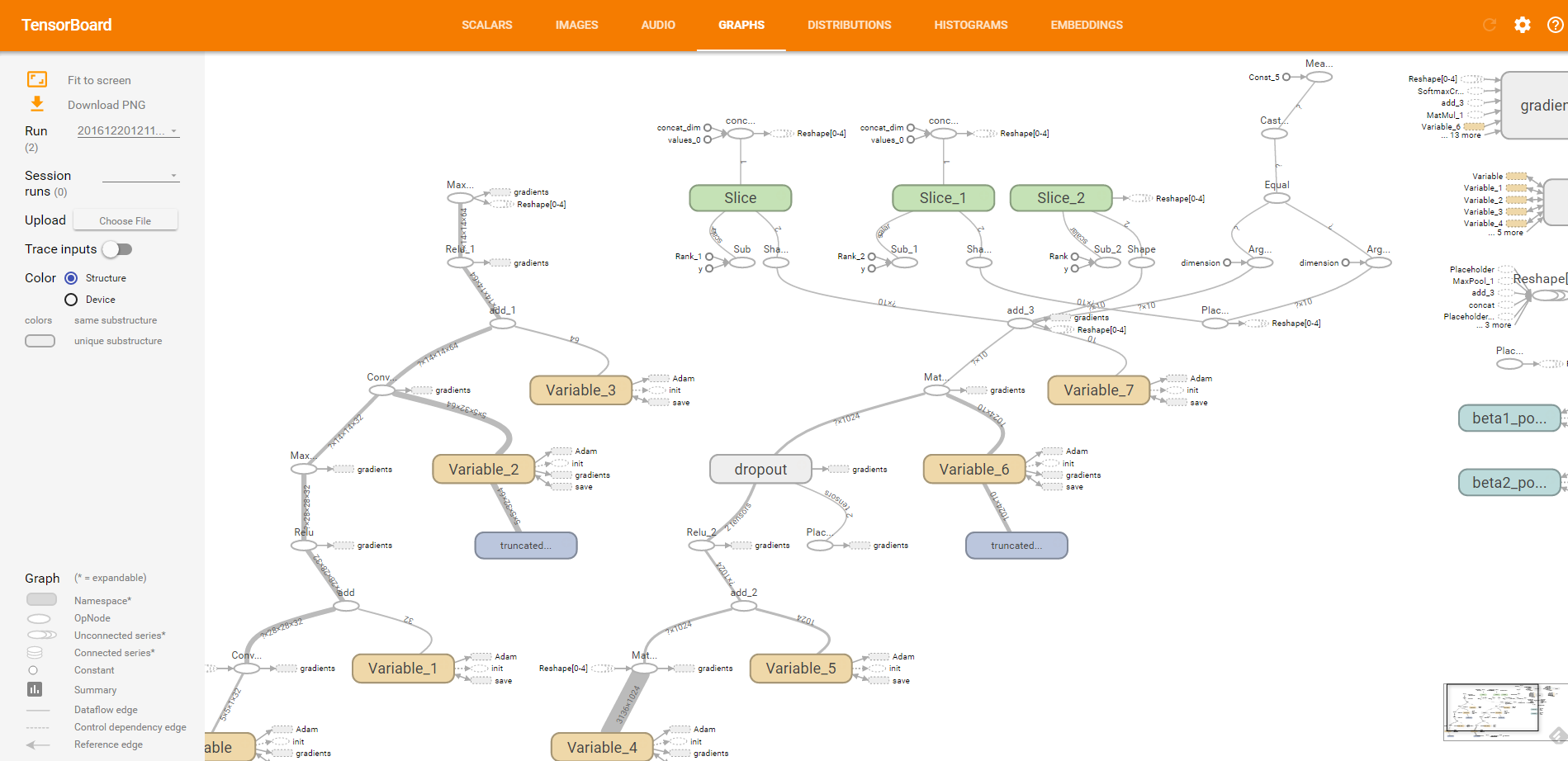

GCP(Google Cloud Platform)を使って、GCE(Google Compute Engine)を起動し、TensorFlowが動くようになるまでを順を追って解説。TensorBoardも動くように設定してみる。

vCPU×16のDebianマシンを立てて動かす。1ヶ月5万円近くの見積が出てきて、ちょっとヒヤリ。これがクラウドじゃなかったらと思うと怖い。

GCPの勉強にもなって良い感じ。きちんと追ってやってくれて優しい。

TensorFlowでMNISTを動かしてみるハンズオン 【フルカワさん】

ディープ・ラーニングの「Hello World!」的な存在であるMNIST(手書き数字の認識)をTensorFlowで体験。

なんだかんだで train.py の実行だけで30分近くかかってしまい、丸山さんは「ディープ・ラーニングでハンズオンしたいと思うのが間違ってるんですよ」なんて、、、それは言っちゃダメですよ。

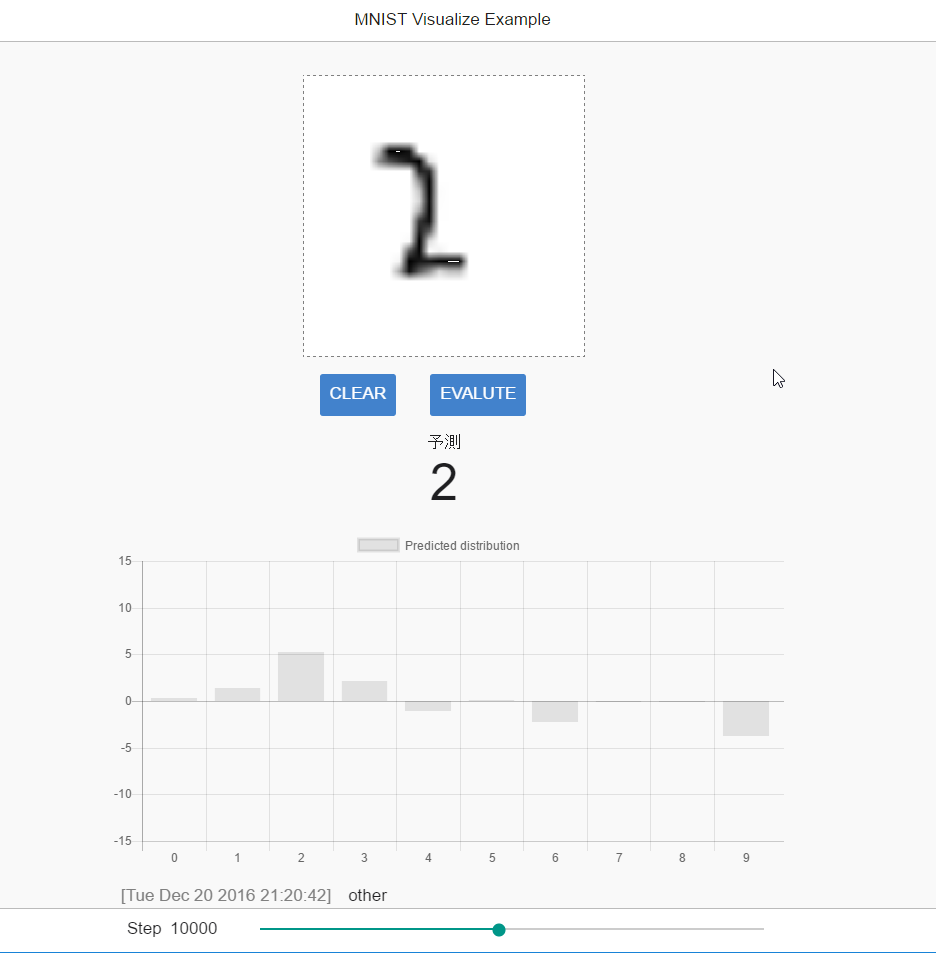

学習ステップ20,000まで実行してみてからやってみると、明らかに1,000の時とは精度が変わったのを確認できて楽しい。

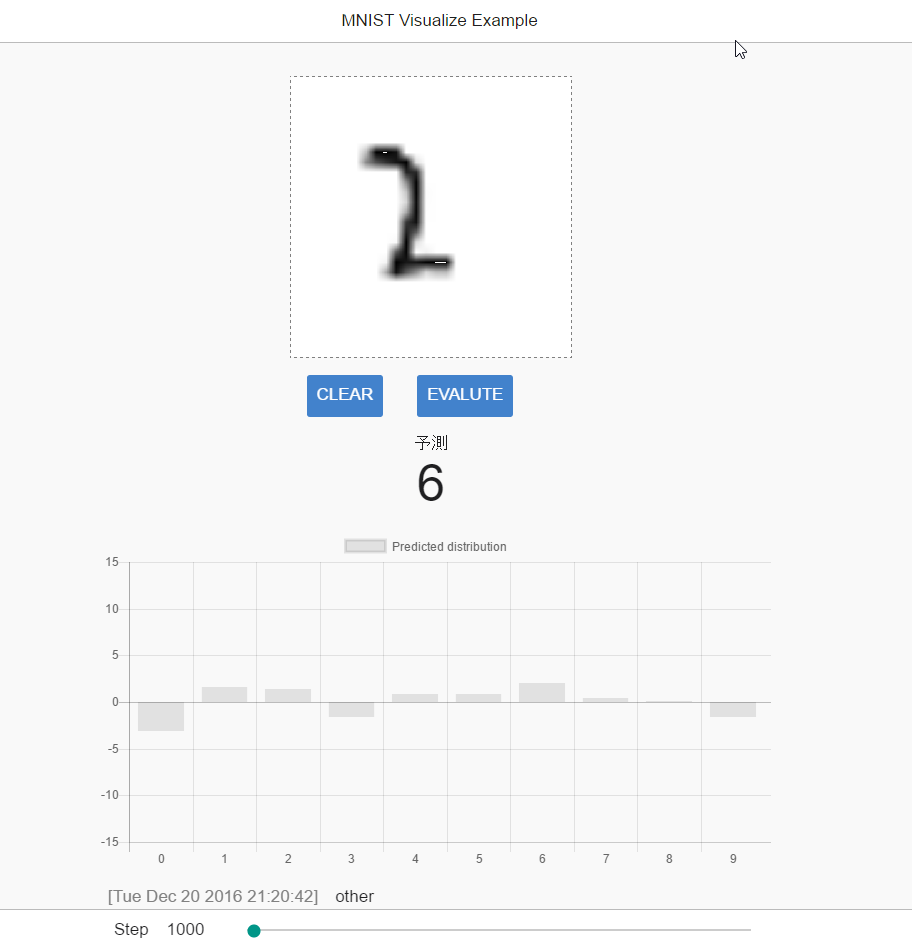

▼学習ステップ1,000のときの判定

「2」っぽく書いた数字が「6」として予測判定されている。。。

▼学習ステップ10,000のときの判定

予測がきちんと「2」になった。

これからどうする?

このままだと何の意味もないので、とにかくソースコードを読み込んでみることとする。

TensorBoardも掘れば掘れそう、少し読み込んでみようと。

▼TensorBoardでは図示されたグラフや、ステップが増えることに学習する様を確認できる